В последние годы всё чаще всплывает термин «большие данные», Big Data. Он появляется в самых разных контекстах, но особенную популярность приобрел в связи с обсуждением темы инноваций, а также открытых данных и их коммерческого потенциала. Попробуем разобраться с тем, что он означает и к чему применим.

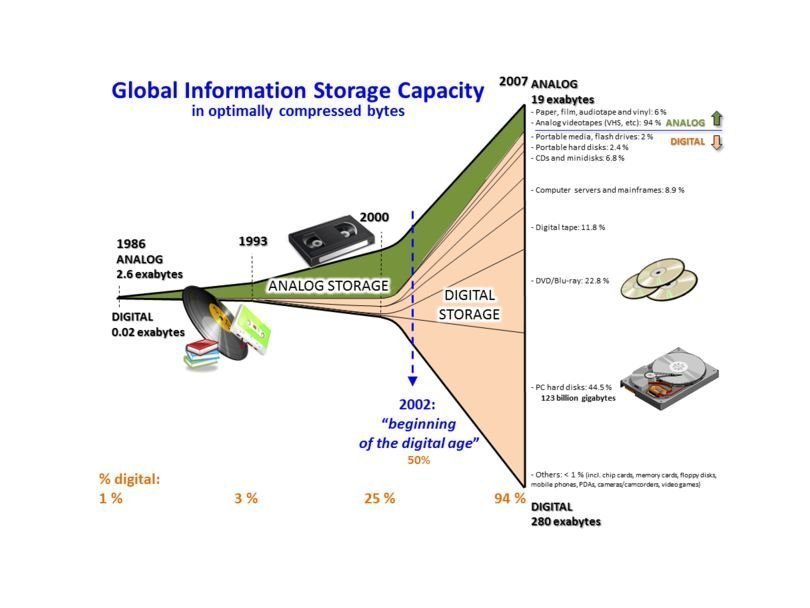

Итак, большие данные – это относительное понятие, значение которого может со временем меняться. Наиболее прямолинейный способ определения – это данные, которые не помещаются на жёстом диске одного компьютера и которые невозможно обработать с помощью традиционных в этой области инструментов, просто потому что они с такими объемами не справляются или справляются, но крайне медленно. Естественно, объемы жестких дисков у разных компьютеров могут быть разными, кроме того вместительность и производительность компьютеров постоянно растет. Однако объемы доступных для обработки данных также постоянно наращиваются. Исходя из этого, всё чаще оказывается более рациональным не увеличивать объемы диска одного компьютера, а развивать методы и инструменты для так называемой облачной обработки данных, которые хранятся частями на нескольких компьютерах. В настоящий момент большими считаются данные объемом от терабайта (1 терабайт = 1024 гигабайт) и до бесконечности, которая на нынешнем этапе практически измеряется в эксабайтах (1 эксабайт = 1 млрд. гигабайт).

Широкой популярностью пользуется определение Майкла Франклина из Университета в Беркли (в частности, его цитирует Билл Хау, автор курса по дата-науке на платформе Coursera): «Большие данные – это любые данные, работа с которыми требует значительных затрат и из которых трудно извлечь информацию». Таким образом, строгого определения не существует. Однако существует объект, с которым нужно как-то работать.

Примеры

Переходя от абстракций к конкретике, приведем несколько примеров. Один из хрестоматийных случаев – это данные Википедии. За время её существования было создано огромное количество статей. Также сохранялась история редактирования этих статей. Будучи одним из классических примеров успешного краудсорсингового проекта, существующего преимущественно на добровольных началах, эти данные могли бы стать большим подспорьем в изучении того, как функционируют такие массовые волонтерские пиринговые инициативы. Явление это совсем новое – до появления интернета такого не могло существовать по техническим причинам, - и набирающее популярность: проектов, устроенных по сходной модели, становится всё больше. Если бы можно было проследить тенденции и закономерности в том, как ведут себя редакторы статей Википедии, это могло бы стать интересным материалом для исследования.

Но все эти истории редактирования представляют собой гигантский массив неструктурированных данных (проще говоря, текста, который не очень понятен машине). Чтобы с ним работать, нужно, во-первых, определить метод, с помощью которого его можно проанализировать, а во-вторых, иметь инструменты, достаточно мощные для того, чтобы они в сжатые сроки могли справиться с такими объемами. В 2007 г. вышла работа нескольких исследователей из IBM и MIT, которые разработали алгоритм, чтобы преобразовывать эти данные в так называемые «хромограммы», которые позволяют увидеть закономерности действий как на макроуровне, так и в более частных случаях.

Но это всего лишь один из множества примеров. Среди них можно также назвать «большие данные», которые хранятся на серверах Google, Amazon и Facebook. Чем быстрее и качественнее будет обработка этих данных, тем эффективнее будут работать эти системы и тем больше у них будет возможностей. Богатый источник данных представляют собой различные приборы наблюдения. Телескоп, используемый Sloan Digital Sky Survey начиная с 2000 г., в первые несколько недель работы собрал больше данных, чем было собрано за всю историю астрономии и с тех пор собирает порядке 200 ГБ данных за ночь. В 2016 г. вместо него загрузят более продвинутую модель телескопа, который, по прогнозам, в первые пять дней работы соберет объем данных, сопоставимый с общим объемом массива, собранного его предшественником. Также с возрастающей скоростью увеличивается количество данных в таких областях, как биология, медицина и генетика.

Наконец, стремительное увеличение масштабов данных происходит за счет того, что стало очень много электронных устройств, которые постоянно и массово используются в самых разных сферах жизни. Прежде всего, речь идет о мобильных устройствах – телефонах, планшетах, ноутбуках и т.д., которые всё время собирают, пересылают и обрабатывают данные.

Проблемы

Проблемы, связанные с большими данными, часто разделяют на три основные группы: объем, скорость, неоднородность (так называемые «3 V»: Volume, Velocity, Variety). Объем – это, в первую очередь, вопрос пространственный: хранение большого количества данных требует особых условий. Скорость – это, в свою очередь, проблема времени. Причем задача не только устранить замедление, которое происходит при обработке больших массивов данных старыми методами, но и значительно ускорить эти процессы. Чем быстрее обработка, тем выше возможности в плане интерактивности. Наконец, проблема неоднородности состоит в том, что данные зачастую происходят из разных источников и бывают в разных форматах и разного качества. Их невозможно просто сложить вместе и обработать – требуются сложная работа, чтобы привести их в пригодный для анализа вид.

При этом надо понимать, что с одной стороны, пределы возможной «величины» данных пока не установлены, то есть эти проблемы сейчас трудно решить раз и навсегда. С другой стороны, для более скромных, но тем не менее больших, объемов (терабайт – это уже большие данные), существуют инструменты и методы обработки, которые применяются, осваиваются и развиваются. Конечно, в разных случаях разные исходные условия. Скажем, у какой-нибудь организации могут быть в распоряжении суперкомпьютеры, а какого-нибудь пользователя один ноутбук. Техники работы с данными, которые сейчас развиваются, учитывают и второй вариант. Одной из наиболее перспективных открытых систем в этой области сейчас считается система Hadoop. Также есть энтузиасты, которые пытаются приспособить к работе с большими данными более камерные аналитические инструменты вроде R.

Кому это нужно

По мере роста объемов данных умножаются возможности их применения и/или коммерциализации в самых разных областях. Данные – это такое описание объекта, ситуации или события, которые, грубо говоря, можно посчитать и тем самым установить в нем закономерности, то есть получить информацию. Установив закономерности, можно создать цифровую модель этого объекта, которую можно использовать в самых разных целях – от сугубо прикладных до весьма абстрактных. С помощью модели можно изучать свойства уже описанного реального объекта, а также делать вероятностные прогнозы. Эти техники широко использовались и прежде – например, в информационных технологиях, социологии или анализе рынка.

По сравнению с прежней картиной изменились два момента. Во-первых, данные стали доступны в большем количестве областей, чем раньше. В частности, по мере оцифровки текстов всё больше возможностей для работы с данными открывается в сфере гуманитарных наук. Во-вторых, изменился масштаб данных. На основании произвольной выборки можно делать некоторые заключения обо всей общности, из которой взята эта выборка, но точность этих заключений зависит от её размеров. Чем больше данных, тем точнее модели и тем выше их ценность. Опять же, чем больше областей знания получают доступ к работе с данными, тем больше возможностей для междисциплинарных исследований и разработок, что позволяет применять новые познавательные методы и создавать новые продукты. Отсюда и массовый интерес к освоению этой области.

Приведем несколько примеров областей, в которых большие данные либо применяются, либо применимы в перспективе. Прежде всего, это экономика и рыночная аналитика – область, в которой анализ данных применяется издавна. Здесь можно вспомнить лекцию американского экономиста и нобелевского лауреата Кеннета Эрроу, в которой он предлагал посмотреть на информацию как на специфический вид товара в условиях неопределенности. Далее, это, конечно, сфера информационных технологий. Это и разработка пользовательского программного обеспечения, и развитие глобальных систем вроде Google, Amazon или Facebook, и, наконец, создание собственно аналитических инструментов. Это также может быть сфера политики и государственного управления. С аналитической точки зрения, это возможность повышать точность оценки тех или иных ситуаций, а также создания вероятных сценариев развития событий. Массовый сбор и анализ данных также может сказываться на принятии государственных решений.

Наконец, работа с большими данными – это важная составляющая современной научно-технической сферы. «Необходимость находить способы работы с большими данными и потребность в том, чтобы извлечь скрытую в них информацию, теперь стало центральной темой во всех науках. Это поистине главная научная тема нашего времени», - писали авторы одной интернациональной (китайско-американской) научной статьи, в которой предлагается возможная модель для анализа продолжительности взаимной торговли на финансовых рынках.

Среди фундаментальных наук это, в частности, социология, биология, медицина, генетика, астрономия, физика, а также многие другие. Так, большие данные позволяют создавать модели, с которыми можно проводить эксперименты, которые были бы слишком дорогостоящими или вообще невозможными в применении к реальным объектам. В области медицины постоянное накопление и анализ больших массивов данных позволяет исследовать причины возникновения заболеваний.

В прикладных областях это один из двигателей инноваций. Здесь и 3D-моделирование в области инжиниринга, и достижения бионики, и автогенераторы текстов, в пределе неотличимых от текстов, написанных человеком, при помощи методов машинного обучения и больших массивов данных, на которых программы тренируются и которые они в дальнейшем преобразуют в связный текст, понятный широкой аудитории.

Снова проблемы

В ответ на массовый ажиотаж по поводу открывающихся возможностей появляется и критика. Прежде всего, аналитики призывают не полагаться чрезмерно на размеры данных: утверждение, что чем больше данных, тем лучше, справедливо только в случае, если данные качественные.

Далее, высказываются опасения, что в отсутствие углубленных представлений о том, какие факторы могут влиять на результаты анализа больших массивов данных, возрастает риск ошибочных суждений. Такие критики призывают уделить больше внимания исследованию именно этой проблематики: «Этот поток исследований [о работе с большими данными], - гласит редакционная статья в International Journal of Internet Science (июль 2012 г.), - выявил очень полезную информацию, но в то же время у него есть серьезные ограничения. Что характерно, к этим ограничениям можно (и даже нужно) подходить, с точки зрения теории – такого рода исследования обычно проводят социологи. Соответственно, возникают задачи для этих социологов и психологов-бихевиористов, которые стремятся к сотрудничеству с исследователями больших данных в области естественных наук, инжиниринга и информатики… У нас есть ощущение, что некоторые пробелы в знаниях еще не получили должного внимания».

Еще одна проблема отчасти связана с вышеупомянутой неоднородностью потоков данных. Тут могут быть и данные о транзакциях, совершенных с помощью банковских карт, и данные по кликам на ссылки в интернете, и данные сенсоров и датчиков на различных устройствах. Данных очень много, но что с ними делать, не всегда понятно. Опять же, если бы эти данные можно было каким-нибудь образом сопоставить, то есть вероятность, что это бы стало ценным источником информации. Но чтобы всё это действительно стало источником информации, необходимо разработать принципы работы с этими данными и понять, какого рода информацию в них следует искать. А это требует серьезного исследования. Недавно три американских университета (Нью-Йоркский, Вашингтонский и Калифорнийский в Беркли) объединились в работе над пятилетним проектом такого рода. «Тут цель не столько в том, чтобы провести научное исследование, - сказал один из участников проекта Йанн ЛеКан, - сколько в том, чтобы организоваться и создать новую дисциплину, среду, в которой бы развивалась наука о данных».

Наконец, обсуждаются также проблемы этического характера: где проходит граница между сбором данных и вторжением в частную жизнь? Google, например, располагает огромным собранием данных, что позволяет ему совершенствовать свои продукты и делать их более надежными для пользователей, а также создавать массово востребованные сервисы вроде Google-переводчика. Он также бдительно следит за действиями пользователей в Сети, что позволяет ему подбирать для каждого пользователя рекламу в соответствии со спецификой этих действий (реклама – это основной источник дохода компании). При этом он не предоставляет пользователям возможность выбирать, какие именно данные они готовы предоставить, а какие хотят оставить при себе. Иными словами, он по умолчанию собирает всё, что сможет, и эти данные будут храниться на его серверах. То, как он ими распорядится, зависит от него, но никоим образом не от пользователей.